| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- logistic regression

- 사회조사분석사2급

- numpy

- 티스토리챌린지

- GIT

- cs231n

- IVI

- CellPin

- vscode

- docker exec

- Pull Request

- ssh

- 백신후원

- AIFFEL

- docker attach

- airflow

- 히비스서커스

- Jupyter notebook

- HookNet

- WSSS

- 도커

- aiffel exploration

- 코크리

- Decision Boundary

- Multi-Resolution Networks for Semantic Segmentation in Whole Slide Images

- docker

- cocre

- 기초확률론

- 프로그래머스

- 오블완

- Today

- Total

히비스서커스의 블로그

[WSSS] EADER 논문 정리 본문

※ Find it if You Can: End-to-End Adversarial Erasing for Weakly-Supervised Semantic Segmentation 의 논문을 읽고 이해한대로 정리해본 글입니다. 아래에 첨부된 그림들 중 논문에 나와있지 않은 그림들은 제가 제작한 내용이니 사용 시 반드시 출처를 남겨주시기 바랍니다. EADER 논문은 핵심 아이디어만 정리하였습니다. 풀잎스쿨 18기 WSSS 논문으로 입문하기를 통해 같이 공부한 분들께 감사를 드립니다.

개인적인 생각

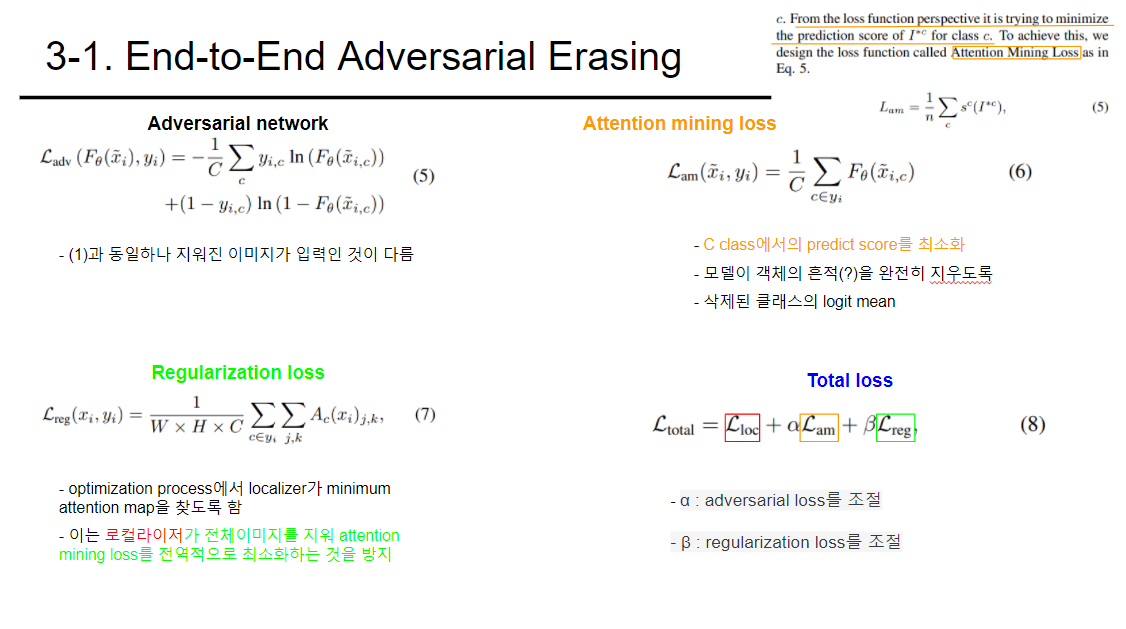

ACoL에 뒤이어 AE(Adversairal Erasing)을 이용하여 End-to-End 방식을 이용한 WSSS 모델을 제시한 논문이다. 핵심아이디어라고 볼 수 있는 부분은 GAN(Generative Adversarial Network)의 학습 방식과 같이 두 Network가 적대적인 (Adversarial) 방식으로 학습해나감을 통해 찾으려는 해당 object의 전체 부분을 추출한다는 것이다. 이를 위해 attention minining loss와 regularization loss를 추가하여 total loss로 사용하였는데 이를 중점으로 이해하는 것이 이번 논문에서 가장 중요한 부분이 아닐까 싶다.

Abstract

- WSSS를 위한 attention map을 추출하기 위해서는 Classification Network가 사용됨

- 하지만 Classification Network는 객체의 가장 분별력있는 최소한의 증거만을 요구함

- 이를 극복하기 위해서 attention map의 adversarial erasing의 공식을 제안함

- 이 방법에서 두 반대되는 loss function을 가지는 network를 최적화 함

- 이전 방법들의 특정한 부차적인 요구사항이 필요 없어짐

- 대표적인 예시로 다른 분포를 가지는 두 network의 가중치를 공유하는 것이 있음

- regularization loss를 사용하여 덜 구별적인 객체 영역으로 attention map이 확장되는 것을 방지함

Method

EADER (End-to-End Adversarial Erasing)

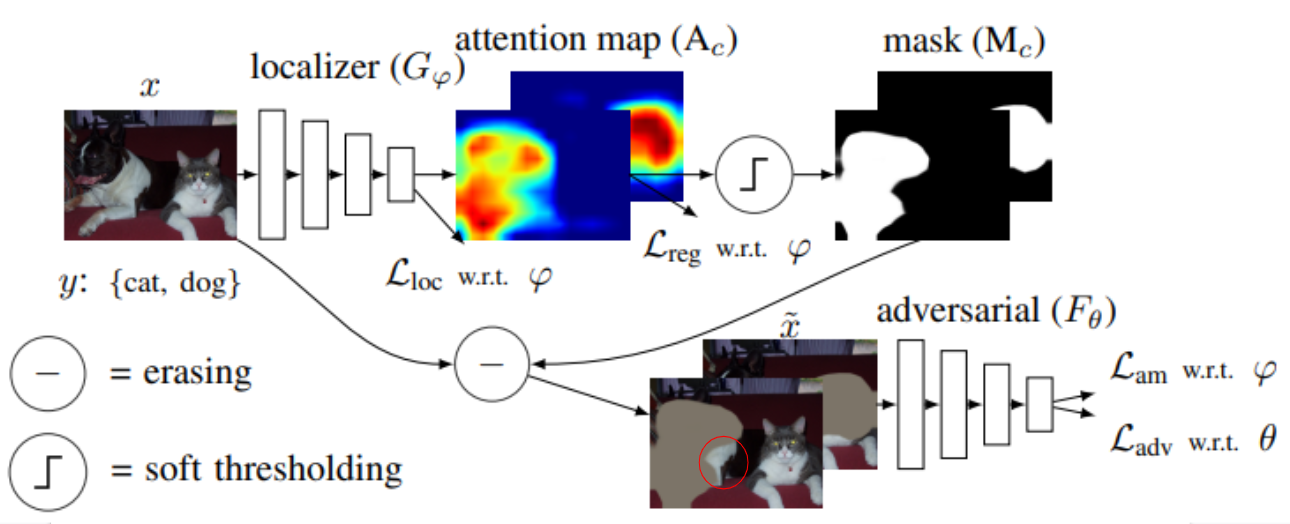

제안된 방법은 크게 두 가지 image classifier로 구성되며 각각의 loss function은 다음과 같다.

- localizer network => binary cross entropy loss + adversarial regularization term

- adversarial network => binary cross entropy loss + adversarial loss term (attention mining loss)

각각의 network와 addtional term에 대한 설명은 아래의 그림을 참조하면 된다.

각각의 부분들을 수식적으로 살펴보자면

위의 그림에서 D 부분은 전체 데이터셋을 의미한다.

Localizer network

Localizer network의 loss function은 일반적인 binary cross entropy loss와 동일한 구조이다.

Attention map

마지막 convolution network를 지난 feature map이 classficiation 가중치 행렬과 곱해지고 activation function인 relu 함수를 지나고 나온 것을 attention map이라 한다.

Soft masks

attention map에서 임계값을 빼준 후 임계값을 넘었으면 1을 넘지 못하였으면 0을 부여한 후 비선형 함수인 sigmoid 함수를 지나게 한다.

Erasing

Soft masks를 1로만 구성된 map에서 빼준 후 다시 입력이미지와 element wise production을 해주어 특정 class만 지워진 attention map을 만든다.

다음으로 지워진 이미지가 adversarial network에 입력으로 들어간다. 이때 adversarial network의 loss fucntion은 binary cross entropy loss이다.

이제 additional loss들을 살펴보자.

Attention mining loss

C class에서의 prediction score를 최소화하는 loss이다. 입력으로 C class의 객체가 일부 지워진 이미지를 통해 구한다.이를 통해 모델이 이미지에서 C class에 해당하는 객체의 흔적을 완전히 지우도록 한다.

Regularization loss

optimization process에서 localizer가 minimum attention map을 찾도록 한다. 입력으로 C class의 객체가 지워지기 전 이미지를 입력으로 받는다.

조금 더 직관적으로 살펴보자면

위의 그림에서 첫번째 localizer를 지난 후 dog class에 해당하는 영역이 거의 지워지고 빨간색 원으로 표시된 부분만 남은 상황에서

- attention mininig loss는 빨간색 원으로 표시된 부분을 없애려는 loss이다.

- regularization loss는 빨간색 원으로 표시된 부분을 유지하도록 하려는 loss이다.

segmentation map을 얻는 과정은 아래의 그림과 같다.

Integrability of End-to-End Adversarial Erasing

EADER은 simple하고 integrable하다.

- 이전 연구의 Pixel-level Semantic Affinity는 CAM을 얻는 방식을 사용했기에 multi stage였으며 객체의 위치를 정확하게 하지 못하였음

- 이전 연구의 Affinity Net은 pseudo segmentation mask를 만들어 학습하게 하였음

이들은 soft threshold를 attention map에 적용하여 가장 분별력있는 부분을 지운 마스크를 만들었다. 그 후 adversarial network에 입력으로 들어가 attention mining loss는 localizer network의 적대적인 loss로 작용하게 하였다.

-히비스서커스-

'Theory > Computer Vision' 카테고리의 다른 글

| [WSSS] SEC 논문 정리 (0) | 2022.02.21 |

|---|---|

| [WSSS] OC-CSE논문 정리 (0) | 2022.02.14 |

| [WSSS] ACoL 논문 정리 (2) | 2022.02.13 |

| [WSSS] AE-PSL 논문 정리 (0) | 2022.02.13 |

| [CS231n 12] Visualizing and Understanding (0) | 2021.09.11 |