| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- CellPin

- 오블완

- IVI

- 코크리

- ssh

- HookNet

- Multi-Resolution Networks for Semantic Segmentation in Whole Slide Images

- Jupyter notebook

- airflow

- 백신후원

- cocre

- docker exec

- Pull Request

- AIFFEL

- 히비스서커스

- 티스토리챌린지

- logistic regression

- docker attach

- numpy

- GIT

- Decision Boundary

- WSSS

- 기초확률론

- aiffel exploration

- vscode

- 프로그래머스

- cs231n

- 사회조사분석사2급

- 도커

- docker

- Today

- Total

히비스서커스의 블로그

[WSSS] SEC 논문 정리 본문

※ Seed, Expand and Constrain: Three Principles for Weakly-Supervised Image Segmentation의 논문을 읽고 이해한대로 정리해본 글입니다. 아래에 첨부된 그림들 중 논문에 나와있지 않은 그림들은 제가 제작한 내용이니 사용 시 반드시 출처를 남겨주시기 바랍니다. SEC 논문은 핵심 아이디어만 정리하였습니다. 풀잎스쿨 18기 WSSS 논문으로 입문하기를 통해 같이 공부한 분들께 감사를 드립니다.

개인적인 생각

지금까지 살펴보았던 AE(Adversarial Erasing)의 기법을 사용하지 않고 seed를 만들어 확장시키는 SRG(Seed Region Growing) 방식의 시발점이 되는 논문이라고 생각한다. 즉, AE의 AE-PSL논문이 SRG에서 SEC논문이라고 본다. SRG 방식의 핵심 개념인 Seed, Expand, Strain의 개념이 WSSS에 어떻게 적용이되는지를 중점으로 살펴보는 것이 핵심이라고 생각한다.

Abstract

WSSS model의 학습을 위해 새로운 loss function을 도입하였음

- Seed loss :: weak localization cue를 뿌리기 위함

- Expand loss :: 이미지 안에서 발생할 수 있는 클래스들에 관한 정보에 근거하여 object를 펼치기 위함

- Constrain loss :: 객체 boundary들과 일치하는 segmentation들을 제약하기 위함

The SEC loss for weakly supervised image segmentation

이들의 방식에 대해 기술적인 부분들을 살펴보자. 먼저 수식적인 부분에 있어서 어떻게 표기하는지와 최종 목표가 무엇인지 아래의 그림을 통해 확인해보자.

3 term의 loss에 최소화하려는 segmentation model의 파라미터 $\theta$를 최적화하려는 것이다. 각각의 term loss가 어떤 역할을 하는지는 다음과 같다.

- Seed term loss :: network에게 localization hint를 제공함

- Expand term loss :: network가 너무 작은 혹은 다른 객체를 가진 segmentation mask를 예측하도록 함

- Constrain term loss :: 이미지의 공간적, 색상적인 면에서 segmentation을 도움

이 3 term loss들을 수식으로 나타내면 다음과 같다.

이제 각각의 term loss들을 자세히 살펴보자.

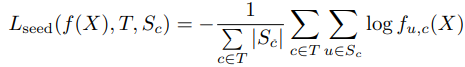

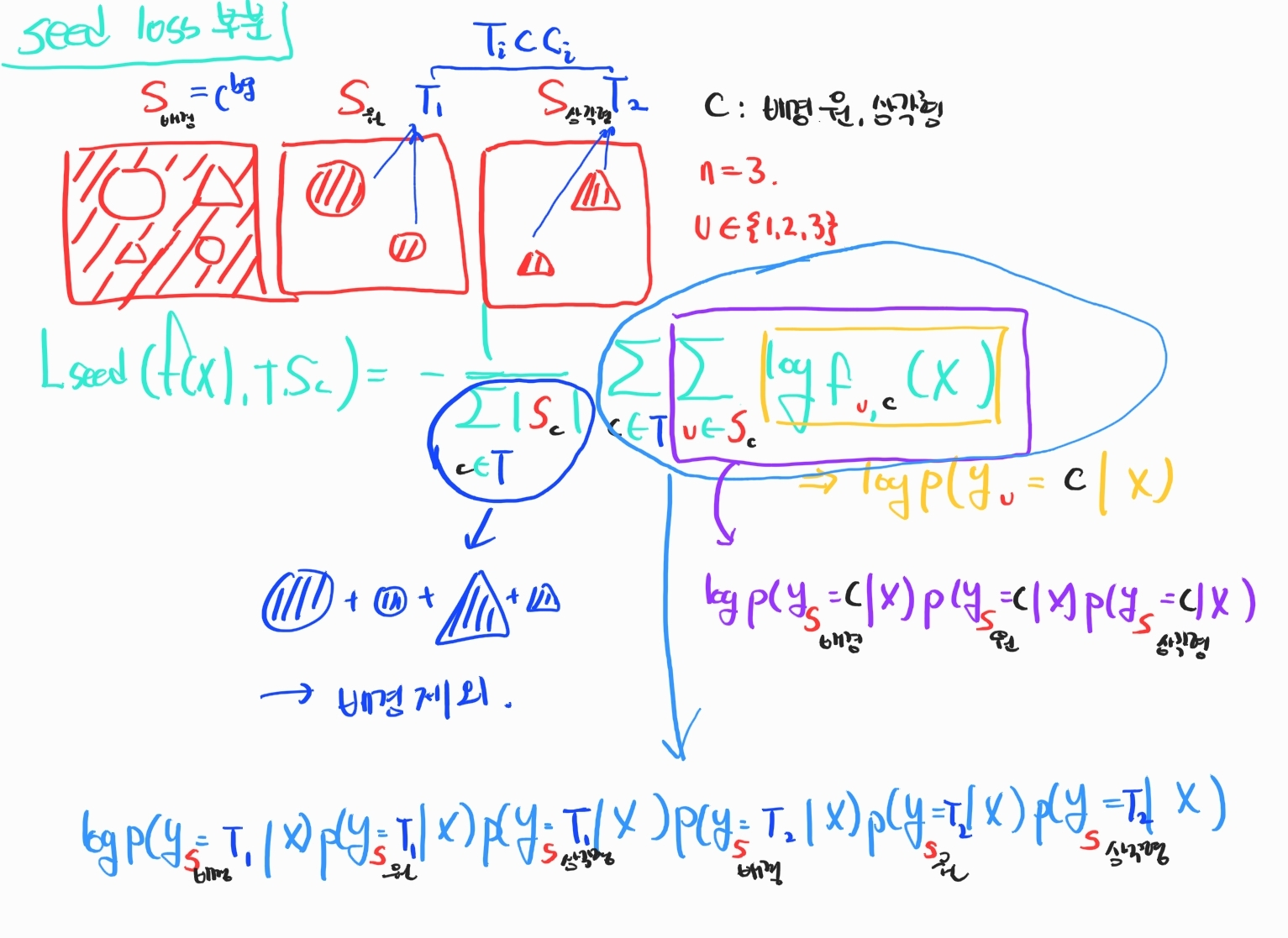

Seeding loss with localization cues

이 과정은 weak localization (여기서 weak localization은 classification network를 통해 object를 localization 하는 과정을 말한다.)에서 제공되는 localization cue는 weakly-supervised segmentation netwrok를 guide하는데 유용하다.

NN(Neural Network)의 예측이 weak localization 절차에 의해 주어진 'landmarks'에만 일치하도록 하기 위해 seeding loss를 사용하고 나머지 이미지는 무시한다.

이 과정에서 gradient-based saliency detection method를 활용하였다.

사용된 loss function 식을 살펴보면 아래와 같은데

이를 좀 더 직관적으로 이해하기 위해 간단한 예시를 들어 식을 풀어보았다.

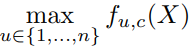

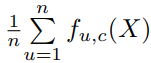

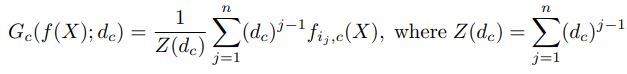

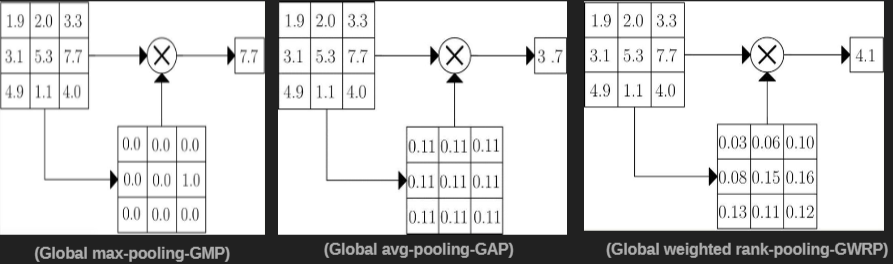

Expansion loss with global weighted rank pooling

segmentation score를 classfication score로 집계하기 위한 방법으로 크게 2가지가 있는데 그 특징은 다음과 같다.

- GMP (Global Max Pooling) :: 최대값만 사용하므로 주변의 영역이 제외될 확률이 높기 때문에 single location만 크게 나옴 (underestimate)

- GAP (Global Average Pooling) :: 평균값을 사용하므로 주변의 영역을 상대적으로 많이 포함될 확률이 높기 떄문에 region 전체가 크게 나옴 (overestimate)

이러한 한계를 개선하고자 이 논문에서는 GWRP(Global Weighted Rank Pooling)을 사용하였다.

- 좀 더 유망한 위치를 가지는 각각의 class의 가중평균 score를 계산해냄

- 이미지의 특정 부분을 차지하도록 함

각각의 적용되는 방식은 아래의 그림을 살펴보면 도움이 될 것이다.

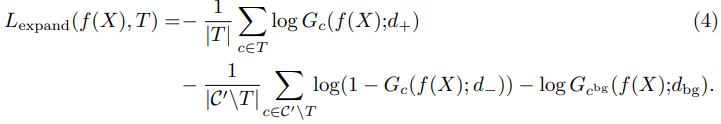

앞에 소개한 GWRP 방식을 이용하여 세 가지 group에 대해 적용하여 loss를 만들어준 것이 expand loss로 그 식은 아래와 같다.

- first group :: 이미지 안에서 발생하는 목표 클래스 d+

- second group :: 이미지 안에서 발생하지 않는 클래스 d-

- third group :: background 클래스

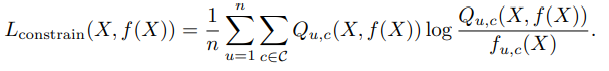

Constrain-to-boundary loss

constrain-to-boundary loss에서의 핵심은 fully-connected CRF의 방식 활용하였다는 점이다. fully-connected CRF의 방식은 유사 위치의 픽셀과 유사 색상의 픽셀은 같은 범주에 속하도록 하되 객체와의 거리도 고려하여 segment하는 방식으로 segmentation 결과가 더욱 섬세하게 하도록 하는 효과가 있다. 따라서, 네트워크가 객체의 boundary와 일치하는 segmentation mask를 생성하는 방법을 학습하도록 한다.

segmentation network에 의해 예측된 확률점수의 로그에 의해 주어진 unary potential과 이미지 픽셀에만 의존하는 pixed parametirc 형태의 pairwise potential을 사용하여 fully connected CRF를 구성하였다. 이미지 X를 downscale하여 segmentation mask와 동일한 resolution(해상도)를 가지게 하였다. (자세한 내용은 Efficient inference in fully connected CRFs with gaussian edge potentials 이 논문을 읽어보길 바랍니다.)

-히비스서커스-

'Theory > Computer Vision' 카테고리의 다른 글

| [Active Learning] Region-Based Active Learning for Efficient Labeling in Semantic Segmentation 논문 정리 (0) | 2022.08.22 |

|---|---|

| [WSSS] CIAN 논문 정리 (0) | 2022.03.10 |

| [WSSS] OC-CSE논문 정리 (0) | 2022.02.14 |

| [WSSS] EADER 논문 정리 (0) | 2022.02.13 |

| [WSSS] ACoL 논문 정리 (2) | 2022.02.13 |